PFDiff: Training-free Acceleration of Diffusion Models through the Gradient Guidance of Past and Future

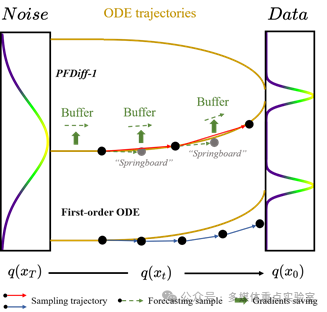

简介: 本文提出了一种名为PFDiff的无需训练的加速采样方法,旨在提升扩散模型(DPMs)的采样效率。PFDiff通过结合过去和未来的分数(scores),提出一种新颖的时间步跳过策略,显著减少了采样过程中所需的函数评估次数(NFE),同时纠正了一阶常微分方程(ODE)求解器的离散化误差。具体而言,PFDiff首先利用过去时间步的分数预测一个“跳板”状态,然后通过前瞻性更新机制利用未来分数快速更新当前中间状态,从而实现高效的采样加速。大量实验表明,PFDiff在多种预训练的扩散模型上表现出色,尤其在条件扩散模型中,以DDIM为基线时,PFDiff在4个NFE下在ImageNet 64×64数据集上将FID从138.81降低至16.46,显著提升了样本质量,展现出超越以往最先进无需训练方法的效果。此外,PFDiff无需额外训练,且与现有扩散模型采样算法正交,在提升扩散模型采样效率方面展现出广阔的应用前景。

论文第一作者是厦门大学信息学院2023级硕士生王广义,通讯作者是苏松志副教授。由2023级硕士生蔡煜人、2022级硕士生李漓江、彭伟(斯坦福大学)共同合作完成。